DeepSeek-R1 lokalnie bez GPU i chmury

DeepSeek-R1 to najnowszy chiński model językowy, który zyskał znaczną uwagę w środowisku sztucznej inteligencji, ponadto jest modelem open-source, Opracowany przez startup DeepSeek z siedzibą w Hangzhou, model ten wyróżnia się na tle konkurencji dzięki swojej efektywności i otwartości. Mimo ograniczeń związanych z dostępem do zaawansowanych półprzewodników, zespół DeepSeek zdołał stworzyć model porównywalny z czołowymi rozwiązaniami zachodnimi, takimi jak OpenAI o1, przy znacznie niższych kosztach.

DeepSeek-R1 jest modelem open-source, co oznacza, że społeczność może swobodnie z niego korzystać, modyfikować go i wdrażać w różnych środowiskach. Jego architektura została zoptymalizowana pod kątem zadań związanych z przetwarzaniem języka naturalnego, takich jak generowanie tekstu, tłumaczenie czy analiza sentymentu. Model ten osiąga imponujące wyniki w testach porównawczych, często przewyższając konkurencyjne modele pod względem dokładności i efektywności.

Jednym z kluczowych aspektów, który przyciąga uwagę do DeepSeek-R1, jest możliwość jego lokalnego uruchomienia na własnym sprzęcie. Dzięki temu użytkownicy mają pełną kontrolę nad danymi i mogą dostosować model do specyficznych potrzeb, bez konieczności polegania na zewnętrznych serwerach. W dalszej części artykułu przedstawimy szczegółowe instrukcje dotyczące budowy komputera oraz konfiguracji środowiska, które pozwolą na efektywne wykorzystanie DeepSeek-R1 w warunkach lokalnych.

Sprzęt – DeepSeek-R1 lokalnie bez GPU

Kompletna konfiguracja sprzętu + oprogramowania do lokalnego uruchomienia Deepseek-R1. Faktyczny model, bez destylacji i kwantyzacji Q8 dla pełnej jakości. Całkowity koszt to TYLKO, 6000 USD. Wszystkie linki do pobrania i części poniżej: Płyta główna: Gigabyte MZ73-LM0 lub MZ73-LM1. Potrzebujemy 2 gniazd EPYC, aby uzyskać aż 24 kanały pamięci RAM DDR5 i maksymalnie wykorzystać rozmiar pamięci i przepustowość.

Płyta główna ~ 1 500,00 euro

Płyta główna: Gigabyte MZ73-LM0 lub MZ73-LM1. Potrzebujemy 2 gniazd EPYC, aby uzyskać aż 24 kanały pamięci RAM DDR5 i maksymalnie wykorzystać rozmiar pamięci i przepustowość.

MZ73-LM0 (rev. 3.x) | Płyta główna serwera – GIGABYTE Global

Procesor AMD EPYC model 9175F 2 x 15 688,69 zł

CPU: 2x dowolny procesor AMD EPYC 9004 lub 9005. Generowanie LLM jest ograniczone przez przepustowość pamięci, więc nie potrzebujesz procesora najwyższej klasy. Wybór modelu AMD EPYC 9175F to opcja droższa ale ma swoje mocne strony 🙂

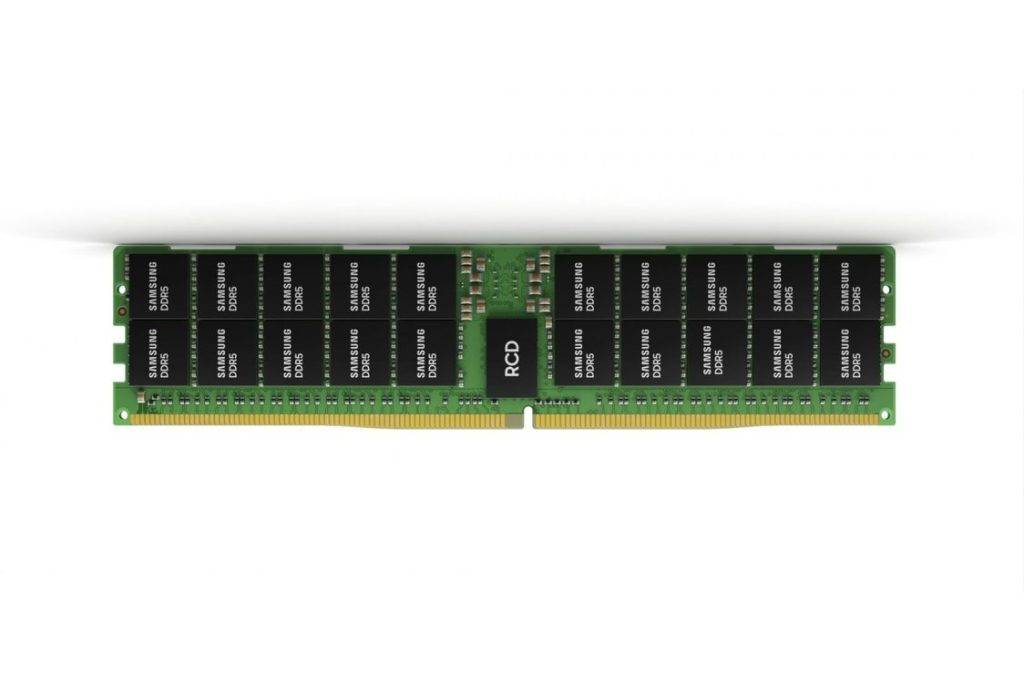

Pamięć 24 x 1400 zł = 26 304 PLN

Będziemy potrzebować 768 GB (aby zmieścić model) w 24 kanałach RAM (aby uzyskać przepustowość wystarczającą do uruchomienia go wystarczająco szybko). Oznacza to 24 moduły DDR5-RDIMM o pojemności 32 GB.

Obudowa

Obudowa: Można ją zmieścić w standardowej obudowie typu tower, ale upewnij się, że ma ona mocowania śrubowe do pełnej płyty głównej serwera, których większość obudów konsumenckich nie ma.

Zasilacz

Pobór mocy tego systemu jest zaskakująco niski! (<700 W) Jednak będziesz potrzebować wielu kabli zasilających CPU dla 2 procesorów EPYC. Corsair HX1000i ma ich wystarczająco dużo

Radiator

AMD EPYC to gniazdo SP5, a większość radiatorów dla SP5 zakłada, że masz serwer typu blade 2U/4U, czego nie mamy w przypadku tego zestawu.

Dyski SSD

Każdy dysk SSD o pojemności 1 TB lub większej, będzie dobry do pracy z R1. Zalecam korzystanie z nośnika NVMe, głównie dlatego, że podczas uruchamiania modelu konieczne będzie skopiowanie aż 700 GB danych do pamięci RAM, co wymaga jak najszybszego transferu.

Tak wygląda twój system! Wystarczy teraz złożyć wszystkie komponenty, zainstalować system Linux i odpowiednio skonfigurować ustawienia.

Ważna wskazówka: Koniecznie wejdź do BIOS-u i ustaw liczbę grup NUMA na 0. Dzięki temu każda warstwa modelu zostanie równomiernie rozłożona na wszystkie moduły RAM, co skutecznie podwoi dostępne pasmo pamięci i poprawi wydajność całego systemu. Nie zapomnij o tym kroku!

Oprogramowanie – DeepSeek-R1 lokalnie bez GPU

Postępuj zgodnie z instrukcjami tutaj, aby zainstalować llama.cpp

GitHub – ggerganov/llama.cpp: Wnioskowanie LLM w C/C++Wnioskowanie LLM w C/C++

Model DeepSeek-R1

Czas pobrać 700 gigabajtów wag od @huggingface! Pobierz wszystkie pliki z folderu Q8_0 tutaj:

unsloth/DeepSeek-R1-GGUF na głównymhttps://huggingface.co/unsloth/DeepSeek-R1-GGUF/tree/main

Finisz – DeepSeek-R1 lokalnie bez GPU

Prawie skończyłeś. Istnieją bardziej eleganckie sposoby konfiguracji, ale dla szybkiej demonstracji, po prostu zrób to w terminalu:

llama-cli -m ./DeepSeek-R1.Q8_0-00001-of-00015.gguf --temp 0.6 -no-cnv -c 16384 -p "<|User|>Ile R jest w strawberry?<|Assistant|>"Jeśli wszystko pójdzie dobrze, powinieneś być świadkiem krótkiego okresu ładowania, po którym nastąpi strumień świadomości, w którym lokalny specjalista LLM zacznie rozważać twoje pytanie:

A gdy przejdzie ten test, po prostu użyj llama-server do hostowania modelu i przekazywania żądań z innego oprogramowania. Teraz masz inteligencję na poziomie granicznym hostowaną w całości na Twoim komputerze lokalnym, wszystko open-source i bezpłatne!

Pamiętaj w tym systemie nie ma GPU! Jeśli chcesz hostować na GPU dla szybszej prędkości generowania, możesz! Stracisz tylko dużo jakości z powodu kwantyzacji, albo jeśli chcesz Q8, będziesz potrzebować >700 GB pamięci GPU, co prawdopodobnie będzie kosztować ponad 100 tys. dolarów, prędkość generowania w tej kompilacji wynosi od 6 do 8 tokenów na sekundę, w zależności od konkretnej szybkości procesora i pamięci RAM, którą otrzymasz, lub nieco mniej, jeśli masz długą historię czatu. Powyższy klip jest niemal w czasie rzeczywistym, nieznacznie przyspieszony, aby dopasować się do limitów długości wideo

Podsumowanie DeepSeek-R1 lokalnie bez GPU

Dlaczego warto używać dużych modeli językowych lokalnie, takich jak DeepSeek-R1?

Wykorzystanie dużych modeli językowych (LLM) lokalnie na własnym sprzęcie niesie za sobą szereg zalet, szczególnie gdy weźmiemy pod uwagę specyfikę modelu DeepSeek-R1 i ograniczenia związane z jego użytkowaniem w chmurze.

Zalety lokalnego uruchamiania DeepSeek-R1

- Brak konieczności przesyłania zapytań do właściciela modelu

- Wysyłanie zapytań do zewnętrznego API jest nie tylko niewygodne, ale także może narazić użytkownika na utratę poufności danych.

- Korzystając z modelu lokalnie, masz pełną kontrolę nad danymi wejściowymi i wynikami generacji.

- Uniknięcie kosztów związanych z odpytywaniem modelu w chmurze

- Modele LLM hostowane przez OpenAI, Google, czy DeepSeek wymagają subskrypcji lub opłat za każde zapytanie.

- Przy dużym obciążeniu koszty mogą znacząco wzrosnąć, a lokalne uruchamianie modeli językowych staje się bardziej opłacalne.

- Brak wymogu stałego połączenia internetowego

- Modele hostowane w chmurze wymagają dostępu do internetu, co może prowadzić do opóźnień i ograniczeń w ich użytkowaniu.

- Lokalny model działa offline, co zwiększa niezależność i bezpieczeństwo.

- Dostosowanie wydajności do własnych potrzeb

- Możesz dostosować konfigurację sprzętową do optymalnej wydajności modelu.

- W twoim przypadku szeroka magistrala pamięci (24 kanały DDR5) zapewni odpowiednią przepustowość do obsługi modelu bez konieczności użycia GPU.

Zalety i wady konfiguracji sprzętowej

✅ Zalety

Gigantyczna ilość RAM-u (768 GB DDR5-4800MHz, 24 kanały)

- LLM-y są ograniczone przez przepustowość pamięci, więc szeroka magistrala i szybkie moduły DDR5-RDIMM zapewnią płynną obsługę modelu.

- Model DeepSeek-R1 zajmuje 768 GB, co oznacza, że mieści się w całości w RAM-ie i nie będzie wymagał swapowania na dysk.

Brak potrzeby użycia bardzo drogich kart graficznych

- GPU z odpowiednią ilością VRAM (np. 8x NVIDIA H100 96 GB) kosztowałoby setki tysięcy złotych, co czyni konfigurację CPU + RAM bardziej opłacalną.

- Wydajność modelu będzie w dużej mierze zależała od szybkości dostępu do pamięci, a nie mocy obliczeniowej procesora.

Stabilność i niezawodność dwuprocesorowej konfiguracji AMD EPYC 9000

- AMD EPYC oferuje doskonałe wsparcie dla wielokanałowej pamięci DDR5, co jest kluczowe dla tak dużych modeli.

- Wydajność CPU nie jest kluczowa, ale szeroka obsługa pamięci i wysoka liczba rdzeni pozwoli na stabilne działanie.

Długoterminowa oszczędność

- Po początkowej inwestycji w sprzęt nie ma dodatkowych kosztów za korzystanie z modelu.

❌ Wady

Bardzo wysoki koszt początkowy

- 24 moduły DDR5-RDIMM 32 GB to koszt rzędu 30 000 – 50 000 zł.

- Płyta główna serwerowa z obsługą 24 kanałów DDR5 oraz 2x AMD EPYC 9000 może kosztować kolejne 30 000 – 50 000 zł.

- Całkowity koszt zestawu wyniesie około 100 000 – 130 000 zł, ale i tak jest znacznie tańszy niż GPU z 768 GB VRAM.

Zajmuje dużo miejsca i zużywa dużo energii

- Serwerowa konfiguracja 2x EPYC 9000 + 768 GB DDR5 będzie pobierać dużo prądu, zwłaszcza przy pełnym obciążeniu. Ale to i tak DUZOOOOOOOO mniej jak w przypadku GPU

- Konieczność zastosowania chłodzenia serwerowego (powietrznego lub cieczą).

Mniejsza optymalizacja pod kątem LLM w porównaniu do GPU

- Modele LLM są optymalizowane pod kątem GPU i mogą działać nieco wolniej na CPU, mimo dużej ilości RAM-u.

- GPU posiadają wysoko wyspecjalizowane jednostki Tensor Cores, których brakuje w CPU.

Konfiguracja jest realnym i efektywnym rozwiązaniem do uruchamiania DeepSeek-R1 lokalnie. Kluczowe zalety to ogromna przepustowość pamięci, brak konieczności użycia bardzo drogich kart graficznych oraz pełna niezależność od chmury, ponadto mamy pewność że nasze pytani są na naszym komputerze . Wysokie koszty początkowe są istotnym minusem, ale w dłuższej perspektywie model lokalny okazuje się bardziej opłacalny niż subskrypcje API.

Jeśli chcesz uzyskać optymalne wyniki, warto rozważyć dostosowanie modelu (np. zastosowanie metody 4-bitowego kwantowania), co pozwoli na oszczędność pamięci i dalsze zwiększenie wydajności. 🚀

Artykuł ten to duże rozwinięcie ciekawej wizji pana Matthew Carrigan który znajduje sie pod tym: adresem

Zachęcam do innych poradników:

Whisper system automatycznego rozpoznawania mowy

Przekierowywanie Portów na Routerze

Popraw bezpieczeństwo komputera

Sztuczna inteligencja – ChaptGPT

Serwis komputerowy Katowice

Anonimowość w sieci – Topowe programy

Przyspiesz działanie komputera